File robots.txt là một trong những file quyền lực nhất trên website nó như một chốt chặn cho phép hoặc từ chốt bot truy cập website của bạn.

Thông thường file robots.txt sẽ luôn nằm ở đường dẫn https://domain.com/robots.txt trong domian.com là tên miền website của bạn.

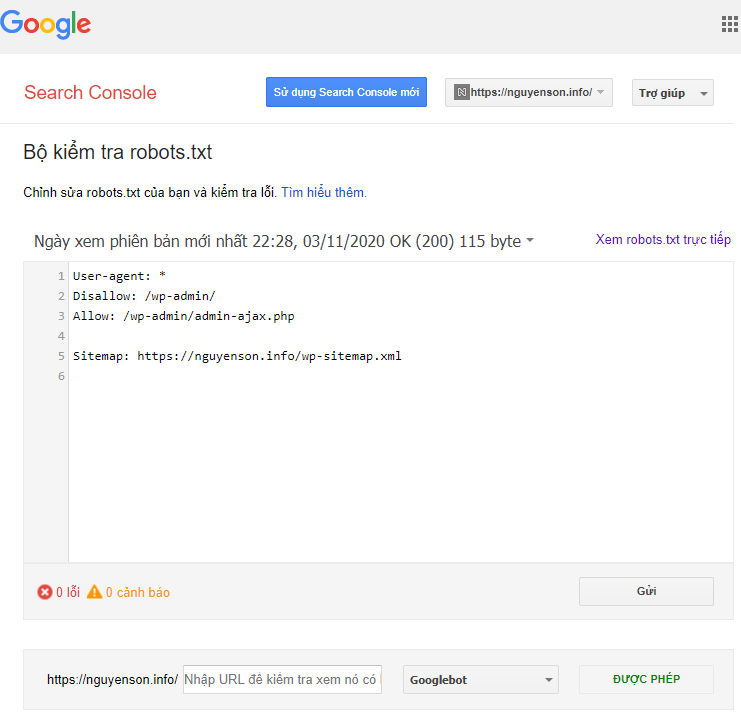

Cấu trúc của file robots.txt

User-agent: *

Disallow: /wp-admin/

Allow: /wp-admin/admin-ajax.php

Sitemap: https://nguyenson.info/wp-sitemap.xmlFile robots.txt có cấu trúc đơn giản mặc định sẽ là User-agent: * tức là cho phép robots truy cập tất cả thư mục trên website.

Ngoài ra Disallow để chặn một thư mục nào đó, Allow là để cho phép truy cập thư mục nào đó, độ ưu tiên giảm dần từ trên xuống dưới.

Như file robots.txt của Nguyễn Sơn cho phép truy cập tất cả trong đó chặn truy cập vào /wp-admin/ nhưng lại cho phép truy cập vào file admin-ajax.php trong thư /wp-admin/

Làm thế nào để biết URL có bị chặn bởi Robots.txt?

Một cách đơn giản là bạn truy cập trực tiếp vào file robots.txt theo đường dẫn https://domain.com/robots.txt và tự kiểm tra.

Một cách đơn giản hơn là Google cho bạn một công cụ kiểm tra robots.txt, truy cập vào link dưới đây:

https://www.google.com/webmasters/tools/robots-testing-toolTuy nhiên điều này chỉ xác định được khi bạn là chủ sở hữu của website, tức là bạn đã thêm website vào Search Console thôi nhé.

Việc kiểm tra robots.txt sẽ giúp bạn biết được URL có bị chặn bởi robots.txt hay không, chặn có đúng hay không?

Ngoài ra sử dụng robots.txt để chủ động chặn những thư mục, url bạn không muốn bot google truy cập cũng là một trong những thủ thuật của dân SEO.

Thẻ meta robots ‘noindex’

Ngoài việc bị chặn bởi robots.txt nội dung trên trang website của bạn cũng chặn bot bằng thẻ meta robots với giá trị noindex.

<!DOCTYPE html>

<html><head>

<meta name="robots" content="noindex" />

(…)

</head>

<body>(…)</body>

</html>Hoặc thẻ chỉ chặn Google bot nhưng không chặn các của các công cụ khác như Bing, Ahref…

<meta name="googlebot" content="noindex">Cách kiểm tra thẻ meta đơn giản là chuột phải chọn xem nguồn trang sau đó tìm kiếm thẻ meta robots có thể sử dụng Ctrl + F và gõ vào giá trị noindex nếu tìm thấy giá trị này ở thẻ meta tức là trang hiện tại đang chặn bot.

Để xóa thẻ này cần can thiệp vào wordpress hoặc một số plugin như Yoast SEO cho phép bạn tùy chỉnh robots của từng bài viết.

Trên đây là cách kiểm tra URL có bị chặn bởi robots.txt hay không hoặc thẻ meta “noindex” nếu có bất cứ khó khăn gì hãy để lại comment ở phía dưới hoặc kết nối với mình nhé.